* 본문은 이기적에서 발행한 빅데이터분석기사 수험서를 공부하면서 작성된 글입니다. 시험 대비한 공부로, 암기가 필요한 부분을 요약/정리합니다.

PART1. 빅데이터 분석 기획

2. 데이터 분석 계획

2-2. 분석 작업 계획

* 데이터 분석 영역

- 저장된 데이터를 추출해 목적과 방법에 맞게 가공한 후, 분석을 수행하고 결과를 표현

2) 데이터 확보 계획

* 데이터 확보를 위한 사전 검토사항

① 필요 데이터 정의

- 분석 목적에 맞는 데이터 정의, 필요 데이터 확보 가능 유무 및 (불가능 시) 대안 고려

- 내외부 협력관계의 담당자 등 이해관계자들과 확보 가능한 데이터 목록 및 기대효과 공동 작성

② 보유 데이터 현황 파악

- 사전에 정의한 데이터 존재 유무 및 품질, 양 확인

③ 분석 데이터 유형

- 분석 계획에 따라 데이터의 유형(정형/비정형/반정형) 선택 및 변수 정의

④ 편향되지 않은 충분한 양의 데이터 규모

- 훈련/검증/테스트 데이터셋으로 나누어 사용할 만큼 데이터 확보 필요

⑤ 내부 데이터 사용

- 데이터 목록(변수 명칭/설명/형태/기간/용량/권한 등) 작성 및 법률이나 보안적 요소 확인(필요 시 비식별 조치방안)

⑥ 외부 데이터 수집

- 외부 데이터 보유 기업 이름 및 데이터 제공 방법 정리(Open API, 복제 등) 및 법률/제도상 제약 검토

* 분석에 필요한 변수 정의

데이터 분석 요건에 따라 도출된 활용 시나리오에 적합한 데이터 유형 및 분석 변수 정의

① 데이터 수집 기획

- 수집 기법을 활용, 필요 데이터를 배치 자동화로 수집 (시스템 혹은 사이트 선별-크롤러/저장소 기획-수집주기 기획)

- 데이터 거래소, 공공 데이터에 적재된 분야별 데이터 분류 및 선별 (분석 대상인 공공데이터 다운로드/저장(NoSQL)계획 수립)

② 분석 변수 정의

- 상관관계 분석 위한 데이터 연속성 범주 등 고려하여 분석 변수 정의

- 분석 변수 유형과 형성 알고리즘 이용, 순수도(purity)/불순도(impurity) 확인 및 순수도 높은 분석 변수 도출

* 분석 변수 생성 프로세스 정의

분석 대상에 대해 객관적으로 인식하고 논리적 인과관계 분석 및 상관관계 분석 위한 분석 변수 생성 프로젝트

① 객관적 사실(Fact) 기반 문제 접근

- 가정(Why)에 의한 접근 방법과 함께 무엇(What)이 문제인지 평가하여 객관적 관찰 데이터 유형 식별

② 데이터 상관 분석

- 분석 대상의 연관성 분석을 통해 데이터 집합 간 통계적 관련성 있는 변수 생성하고 변수의 척도 분류

③ 프로토타입 통한 분석 변수 접근

- 프로토타이핑 접근법을 통해 결과를 확인하고 반복적으로 개선하면서 필요한 데이터를 식별

- 비정형 데이터가 갖는 문제 해소

※ 빅데이터 분석 시 대부분 비정형 데이터 → 사용자가 데이터 정보 및 분석변수 규정 어려움

* 생성된 분석 변수의 정제를 위한 점검항목 정의

- 분석 기획 단계에서 도출된 문제 인식 + 해결을 위한 개념적 대안 설계 → 도출된 데이터의 가용성 평가 / 점검항목 정의

- 데이터 가용성/적정성 부족 시 문제 해결 및 시나리오 적용 어려움 → 실행 전 분석 변수를 논리적 지표에 따라 점검

* 생성된 분석 변수의 전처리 방법 수립

- 데이터 정제를 위한 점검이 끝나고, 이에 맞게 논리적 모형 설계를 위한 전처리 방법 수립

- 빅데이터 분석 프로세스 수행 시, 다양한 업무와 도메인이 포함되어 있어 완전 자동화 처리는 어려움

※ 정제와 통합을 통해 약 60~80% 처리됨

* 생성된 변수의 검증 방안 수립

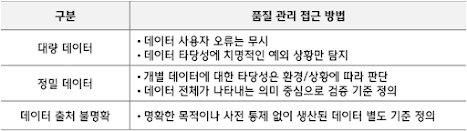

- 모든 데이터의 타당성보다 빅데이터 개념 및 특성 측면에서 관리되어야 하는 항목/수준의 품질 검증 정의

- 빅데이터 품질 관리 및 검증은 정확성보다 데이터 양의 충분성 개념하에 Biz 영역/목적 따라 검증

- 데이터 검증 체계를 수립하여 데이터 출처 / 중복 데이터 / 정보 활용 컴플라이언스 이슈

/ 데이터 다양성 / 데이터 충분성 / 품질지표 만족 여부 / 분석-검증-테스트 데이터 분리 여부 검증

※ 컴플라이언스(Compliance) : 사업 추진 과정에서 기업 자발적으로 관련 법규를 준수하도록 하는 시스템

3) 분석 절차와 작업 계획

* 분석 절차

- from 문제인식 to 결과 도출 일반적인 과정을 정형화 한 프로세스

- 분석 방법론을 구성하는 최소 조건이며, 상황에 따라 단게 추가/생략 가능

- 분석 절차 적용 시, 구체적 문제 정의 / 필요 데이터 보유 / 분석 역량은 필수

- 문제의 구체적 정의가 없다면 데이터 마이닝 기반으로 분석 후 인사이트 발굴하거나

일단 분석 시도 후 결과 확인해가며 개선 결과 도출 가능 (~프로토타입 접근법과 유사)

※ 데이터 수집 → 젖아 → 처리 → 분석 → 시각화 → 이용 → 폐기 단계로 정의할 수도 있음

* 작업 계획

분석 절차에 따라 데이터 분석 업무를 수행하기 위한 전반적인 작업 내용을 세부적으로 정의

※ 분석목표정의서 : 현실적인 분석 목표 수립하여 데이터 정보 / 분석 타당성 검토 / 성과측정 방법 정리

[작성 방법] 목적 → 세부 목표 → 데이터 정의 → 수집 / 분석 방법 / 난이도 / 검증기준 → 도메인 개선방향

구성요소1) 원천데이터 조사 - 데이터 정보 및 데이터 수집 난이도 조사

구성요소2) 분석 방안 및 적용 가능성 판단 - 개선목표 vs. 분석목표 간 차리 고려, 분석 목표 조정

구성요소3) 성과평가 기준

- 정성적 : 기술 활용 가능성 / 신규 데이터나 외부 데이터 활용 가능성 / 세분화나 군집화를 통한 집단 선정

- 정량적 : 기존 대비 효과 증감 비율 / 유효한 가설의 수 / 데이터 모형의 정확도 / 자체 KPI 성과 측정

※ WBS : 프로젝트 범위와 최종 산출물을 세부요소로 분할한 계층적 구조도

[단계1] 데이터 분석과제 정의

- 분석목표정의서를 기준으로 전체 일정에 맞춰 사전에 준비

- 각 단계별 필요 산출물과 보고서 작성 시기, 세부 일정 등을 정리

[단계2] 데이터 준비 및 탐색

- 데이터 엔지니어가 데이터를 수집하고 정리하는 일정 수립

- 데이터 분석가가 변수 후보를 탐색하고 최종 산출물을 도출하는 일정 수립

- 데이터 분석 가설을 세우고 유의미한 검정(가설이 맞는지 틀린지 판단)을 수행하는 일정 포함

[단계3] 데이터 분석 모델링 및 검증

- 실험방법 및 절차를 구분해 검증(틀릴 가능성이 없음을 밝혀내는 것)하는 내용과 수행일정을 상세히 수립

- 모델링 작업이 1회 이상 수행되므로 검증일정을 고려하여 세부일정 수립

[단계4] 산출물 정리

- 분석 단계별 산출물 정리 (모델링 과정에서 개발된 분석 스크립트)

- 전체 일정에서 산출물 정리 과정을 반드시 포함

4) 분석 프로젝트 관리

* 분석 프로젝트

- 과제 형태로 도출된 분석 기회를 프로젝트화 하여 그 가치를 증명하기 위한 수단

- 도출된 결과의 재해석을 통한 지속적인 반복과 정교화가 수행되는 경우가 대부분

→ 데이터 영역과 비즈니스 영역에 대한 이해와 반복이 요구되는 분석 프로세스 이해를 통해 관리방안 수립

- 지속적인 개선 및 변경을 염두에 두고 기한 내 최선의 결과를 도출할 수 있는 협업 필요

- 분석가 = 데이터↔비즈니스 중간에서 현황 이해 및 분석 모형 통한 조율을 수행하는 조정자 + PJT 관리자

- 중점 관리 영역 ↓

* 분석 프로젝트 관리

- 효율적인 데이터 분석을 위해 범위/일정/품질/이슈/리스크/의사소통 등 영역별로 고려할 요소가 많음

- 데이터 분석이 갖는 기본 특성(5V)을 살려 프로젝트 관리 지침 및 영역별 체크리스트 형태로 관리 필요

- KSA ISO 21500으로 정의된 10개의 프로젝트 관리 지침 체계

① 범위 관리 (Scope)

- PJT범위는 분석 수행하며 데이터/알고리즘에 따라 빈번히 변경되며 PJT지연의 중대 사유

- 최종 결과물이 보고서인지 시스템인지에 따라 투입되는 자원/범위가 달라지므로 사전에 충분히 고려

② 일정 관리 (Time)

- 기획 의도와 달리 반복 과정에서 많은 시간이 소모

- 분석 결과 품질 보장 전제 하, Time Boxing(≒시간표) 기법으로 일정 관리 필요

③ 원가 관리 (Cost)

- 외부 데이터 활용 시 데이터 구입 및 수집을 위한 비용 소모. 사전에 충분한 조사 필요

- 오픈 소스 도구 사용하지 않고 상용 도구 사용 시 발생하는 비용 조사 필요

④ 품질 관리 (Quality)

- 품질 목표 사전 협의 및 통제 필요

- 프로젝트 품질 = 품질관리계획 + 품질통제 + 품질보증

⑤ 통합 관리 (Integration)

- PJT 관리 프로세스들을 통합적으로 운영될 수 있도록 관리

⑥ 조달 관리 (Procurement)

- 상황에 따라 아웃소싱 수행 가능.

- PoC와 같은 지속성 보장되지 않은 PJT는 인프라 구매 보다 클라우드 대여 방식 고려

⑦ 인적자원 관리 (HR)

- 핵심인재 전문분야와 보유 역량 및 수준을 관리하고, 투입 시점과 피로도 등을 종합적으로 관리

⑧ 위험 관리 (Risk)

- 발생할 수 있는 위험 식별 및 대응 방안 수립

⑨ 의사소통 관리 (Communication)

- 다양한 의사소통 채널과 이해관계자가 분석 결과를 공유할 수 있도록 시각화 방안 마련

⑩ 이해관계자 관리 (Stakeholder)

- PJT에 영향을 미치는 이해관계자와 데이터/분석/시스템 등 전문가 관리

![[빅분기] PART4. 빅데이터 결과 해석 - 분석결과 해석 및 활용 - 분석결과 활용 (출제빈도 : 하)](https://blogger.googleusercontent.com/img/b/R29vZ2xl/AVvXsEj2tCMzQ5D2rhqkDfbphh9LKohFnYl3Df8LahM8gskD0BNHA5jX1MLhVIuG78S5IdyrrQrB60ygONq5FvYBLzrUnJrOhKpTfTFzZP0TFS_lZDipN44DhIq8FfFfnieRwTSzDCXvKacFQWvlcETOaoxXS0KNSFdN3apRHi5ReqUer7jCvbIFp2tj8Gmqci3S/w680/%EB%B9%85%EB%8D%B0%EC%9D%B4%ED%84%B0%20%EA%B5%AC%EC%B6%95%EB%B0%A9%EB%B2%95%EB%A1%A0%20%EB%B9%84%EA%B5%90.png)

0 댓글