* 본문은 이기적에서 발행한 빅데이터분석기사 수험서를 공부하면서 작성된 글입니다. 시험 대비한 공부로, 암기가 필요한 부분을 요약/정리합니다.

PART1. 빅데이터 분석 기획

2. 데이터 분석 계획

2-1. 분석 방안 수립

1) 데이터 분석

인사이트발굴/공유/의사결정지원을 목표로 데이터를 정의/수집/변환/모델링/시각화 하는 과정

(국자직무능력표준, NCS : National Competency Standards)

* 데이터 분석 현황

- 무한한 비즈니스 잠재력을 규명하는 초기 프로젝트에 머무르고 있다. ('22) - 장애물은 비용보다 분석을 수행하기 위한 방법과 성과에 대한 이해의 부족

* 데이터 분석 지향점

(1) 전략적 통찰이 없는 데이터 분석 배제

- 단순히 분석을 자주 수행하는 것이 경쟁우위를 가져다 주지 않음

- 전략적 통찰을 가지고 경쟁의 본질을 제대로 바라보는 분석이 필요

(2) 일차원적인 데이터 분석 지양

- 업계 내부의 문제에만 중점을 두는 경우 Biz.관점의 핵심적인 역할 기대가 어려움

(3) 전략 도출을 위한 가치 기반 데이터 분석 지향

- 사업 관련 트렌드 청사진을 그리고, 인구통계적 변화/사회경제적 트렌드 및 고객니즈 변화를 고려해 분석 수행 필요

(4) 데이터 분석에 대한 회의론

- 솔루션 도입 후 과제 발굴/수행 고민이 반복되며 고가 솔루션이 방치됨 (대부분의 성공사례가 기존 분석 프로젝트 재포장 사례, '22)

(5) 데이터 분석 시 고려사항

- 데이터 분석은 규모가 아니라 어떤 시각과 통찰을 얻을 수 있는가의 문제

- 전략/Biz. 핵심 가치에 집중 + 분석 평가지표를 개발하여 대응하는 것이 중요

2) 데이터 분석 기획

: 실제 분석 수행에 앞서, 수행할 과제의 정의, 의도했던 결과를 도출할 수 있도록 관리하는 방안을 계획하는 작업

※ 목표(What)를 달성하기 위해(Why) 어떤 데이터를 가지고 어떤 방식으로(How) 수행할 것인가?

* 분석 기획의 특징

① 분석 대상(What)과 방법(How)에 따른 분류 (아래 : 데이터 분석 주제 유형)

② 목표 시점에 따른 분류

(1) 단기적 접근 방식 (과제 중심적 접근)

- 당면 과제를 빠르게 해결하기 위한 목적, 명확한 해결을 위한 Quick-Win 방식으로 분석

(2) 중장기적 접근 방식 (마스터 플랜 접근)

- 지속적인 분석 문화 내재화 목적. 전사적으로 장기적 관점의 과제 도출 및 수행

(3) 혼합 방식 (분석 기획 시 적합)

- 분석 가치 증명 및 공감을 위해 빠르게 해결하여 가치를 조기에 체험시킴 (Best Practice)

- MP 수립 후 장기적 관점에서 접근하는 것이 바람직 함

* 분석 기획 시 필요 역량

(1) 기본 소양 : 도메인(Domain) + 정보기술(IT) + 수학/통계(Math/Stastics)

(2) 프로젝트 관리 역량과 리더십

* 분석 기획시 고려사항

(1) 데이터 확인 : 데이터 확보 가능 여부 / 데이터 유형 미리 확인

(2) 사례 탐색 : 유사 사례는 적극 활용하는 것이 유리 (사용자 측면 공감대 형성이 쉬움 + 분석이 원활)

(3) 발생 가능한 요소 고려 : 분석에 필요한 기간/자원 요소 + 실제 적용하기 위한 Domain 환경

3) 분석 마스터 플랜과 로드맵 설정

* 분석 마스터 플랜 : 과제를 수행함에 있어 목적/목표에 따라 전체적인 방향성을 제시하는 기본 계획

일반적인 정보전략계획 방법론을 활용할 수 있다. 다만 분석 기획의 특성을 고려하여 수행

: IT 및 시스템을 전략적 활용하기 위한 중장기 MP 수립 절차 → 요구사항을 확인하여 시스템 구축 우선순위를 결정한다.

(1) 우선순위 평가 기준

① IT프로젝트의 우선순위 평가 기준 : 기업에서 고려하는 중요 가치기준에 따라 평가

② 데이터분석 프로젝트 우선순위 평가 기준 : IT pjt와 달리, 기업에 처한 상황에 따라 달라질 수 있음

③ 분석 ROI 요소 고려한 우선순위 평가 기준

(2) 우선순위 선정 및 조정

① 난이도와 시급성을 기준으로 분석 과제 유형을 4분면에 배치한다 (포트폴리오 사분면 분석 기법)

② 매트릭스 내 분석과제 우선순위 선정

(우선순위 = 시급성) III → IV → I → II (우선순위 = 난이도) III → I → IV → II

③ 매트릭스 내 분석과제 우선순위 조정

- 시급성&난이도 모두 높은(1사분면) 과제는 의사결정을 통해 조정 가능

- 데이터 양/특성 및 분석범위 등에 따라 난이도 조율하여 우선순위 조정 (ex. 난이도 조절하여 I → III 이동)

※ [기술요소에 따라 우선순위 조정 시]

새로운 기술은 운영중인 시스템에 영향을 줄 수 있음. 영향을 최소화 하거나 운영시스템과 분리하여 난이도 조율 필요

[분석범위에 따라 우선순위 조정 시]

과제 전 범위를 한번에 진행하는 것 vs. PoC로 진행하는 것 등 범위를 조정할 수 있음

* 분석 로드맵 설정 : MP에서 정의한 목표 기반, 과제 수행하기 위한 필요한 기준을 담은 종합 중장기 계획

- 최종적으로 실행 우선순위를 결정하여 단계적 계획을 수립한다,

- 이때, 단계별로 추진하고자 하는 목표를 명확하게 정의하고, 과제별 선행 관계를 고려하여 단계별 추진 내용을 정렬한다.

- 로드맵 수립 후 과제별 세부적 이행 계획은 반복적인 정련과정을 통해 완성도를 높여 나간다.

- 데이터 수집/확보/준비 단계는 순차적으로 하되, 모델링 단계는 반복적으로 수행하는 '반복형'을 주로 사용

4) 분석 문제 정의

* 분석 문제 정의 개요

① 분석과제 도출 : 해결할 다양한 문제를 데이터 분석 문제로 전환, 과제정의서 형태로 도출

② 대표적 과제 도출 방법

- 하향식 접근방식 : 문제 → 해결방법

- 상향식 접근방식 : 데이터 기반 문제 재정의 & 해결방안 탐색

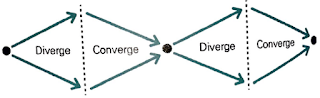

③ 최적의 의사결정을 위한 혼합방식

- 동적인 환경에서 발산(Deverge)/수렴(Converge)를 반복하며 상호 보완을 통해 분석 가치 극대화

(신상품 개발이나 전략 수립 등 중요한 의사결정 필요할 때 주로 사용)

- 상향식 접근 방식의 발산 단계 : 가능한 옵션을 도출

하향식 접근 방식의 수렴 단계 : 도출된 옵션을 분석하고 검증

④ 분석 과제 정의서 : 프로젝트 수행 이해관계자가 프로젝트 방향 설정 및 성공여부 판단 근거 자료로 사용

- 필요한 데이터 / 데이터 수집과 분석 난이도 / 분석 방법과 수행 주기 / 상세 분석 과정 / 검증 책임자 등 포함

- 분석 데이터는 내/외부 데이터 모두 포함하며, 유형이나 종류를 가리지 않고 확장하여 고려

- 정의서는 향후 프로젝트 수행계획의 입력물로 사용

* 하향식(Top-down) 접근 방식

: 문제가 주어지고 해법을 찾기 위해 단계적으로 수행하는 전통적 분석 과제 발굴 방식

근래의 문제들은 변화가 심하여 문제를 사전에 정확하게 정의하기 어렵다

① 문제 탐색 (Discovery) : 기준모델로써 기업 내/외부 환경을 포함하는 Biz. 모델과 외부 참조 모델이 있음

- 개별 인지 모델을 단순히 나열하는 것 보다 전체적 관점의 기준 모델을 활용해 누락 없이 문제 도출 및 식별 필요

- 데이터 여부 및 해결방안에 대한 세부내용보다 문제 해결 후 발생하는 가치에 중점을 둔다

(1) Biz.모델 기반 문제 탐색

[비즈니스모델 캔버스의 단순화]

- 사업 모델을 도식화한 Biz.모델 캔버스의 9개블록을 단순화하여 문제발굴3개단위 + 관리2개영역으로 도출

[업무(Operation)] 제품/서비스 생산 위한 내부 프로세스 및 주요 자원과 관련한 주제 도출

[제품(Product) ] 생산/제품/서비스 개선 위한 주제 도출

[고객(Customer)] 제품/서비스 제공받는 사용자나 제공하는 채널 관점 주제 도출

[규제와 감사(Audit&Regulation)] 생산/전달 과정시 발생하는 교제 및 보안 관점 주제 도출

[지원 인프라(IT & HR)] 분석을 수행하는 시스템 및 운영/관리 인력 관점 주제 도출

- 새로운 관점의 접근으로 새로운 유형의 분석 기회 및 주제 발굴

(2) 외부 참조 모델 기반 문제 탐색

- 유사 혹은 동종 환경 사례 B/M → 분석 테마 후보 그룹 통해 Quick & Easy 방식 접근

(3) 분석 Use-case 정의 (도출한 분석 기회들을 구체적인 과제로 만들기 전 use-case로 정의 필요)

- 문제 상세 설명 및 기대효과를 명시하여 분석 과제로의 전환 및 적합성 평가에 활용

② 문제 정의(Definition)

- Biz. 문제를 데이터 분석 문제로 변환하여 정의(분석 수행자 외 효용을 얻을 최종 사용자 관점에서 정의)

③ 해결방안 탐색(Search) : 문제 해결 위한 방안 모색, 기법(How) 및 분석역량(Who)에 따라 세분화

④ 타당성 평가(Feasibility Study) : 과제화 하기 위한 타당성 분석

- 경제적 타당성 : 비용 대비 편익 분석 관점의 접근 필요 (데이터/시스템/인력/유지보수 등 분석 비용)

- 데이터 및 기술적 타당성 : 데이터/분석시스템 등 분석 역량 분석 + 역량 확보 방안 + Biz/Data/System 엔지니어 협업

* 상향식(Bottom Up) 접근 방식

- 문제 정의 자체가 어려운 경우 데이터 기반으로 문제 재정의 및 해결방법 탐색, 개선하는 방식

→ 문제의 구조가 분명하고, 문제 해결을 위한 데이터 및 분석가가 의사결정자에 주어져 있음을 가정

- 데이터 분석을 통해 왜(why) 그런 일이 발생하는지 역으로 추적해서 문제를 도출/재정의하는 방식

- 데이터 활용, 생각하지 못했던 인사이트 도출 및 시행착오 통한 개선 가능

※ 하향식 문제 방식 한계 ① 새로운 문제 탐색 어려움 ② 복잡하고 다양한 환경 연계 문제에 부적합

- 상향식 접근방법 활용 전통적 분석 사고 극복 방법

(1) 디자인 사고 접근법(Design Thinking)

- 현장 관찰과 감정이입, 대상 관점으로 전환을 수행

- 사물을 있는 그대로 인식하는 What 관점으로 접근 (통상적으로는 사물을 인식하려는 Why강조)

- 객관적으로 데이터 자체를 관찰하고 실제 행동으로 옮김으로써 대상을 잘 이해하는 방식

(2) 비지도학습 방법에 의한 수행

- 새로운 유형의 인사이트 도출을 위해 데이터 자체만을 가지고 결과값을 도출

(3) 빅데이터 환경에서의 분석

- 통계적 분석 → 가설 설정, 표본 추출 후 가설검증 방식의 인과관계 분석

- 빅데이터 분석 → 인과관계, 상관관계, 연관분석을 통해 다양한 문제 해결

- 상향상 접근방식의 문제 해결 방법, 프로토타이핑 접근법

: 일단 분석을 시도해보고 결과 확인 후 개선을 반복하는 방법

요구사항 및 데이터 정의가 어렵고 명확하지 않을 때 유용.

완전하지 않지만 신속하게 해결책/모형을 제시하여 문제를 더 명확히 인식하거나 데이터를 식별할 수 있음

5) 데이터 분석 방안

* 분석 방법론

데이터 분석을 효과적으로 수행하기 위해 분석 절차를 체계적으로 정리한 방법

① 분석 방법론의 구성요건

- 상세한 절차 (Procedures)

- 방법 (Methods)

- 도구와 기법 (Tools & Techniques)

- 템플릿과 산출물 (Templates & Outputs)

- 최소한의 지식으로도 활용 가능한 수준의 난이도

② 분석 방법론 생성 과정 (일본 경영학자 노나카 이쿠지의 지식창조 메커니즘을 바탕)

[형식화] 분석가의 경험을 바탕으로 정리되어 문서화 되는 과정

[체계화] 문서화한 형식지를 절차 / 활동 및 작업 / 산출물 / 도구 등을 정의하여 최적화 시키는 과정

[내재화] 전파된 방법론을 학습하고 활용하여 내재화 하는 과정

* 계층적 프로세스 모델 구성

분석 방법론은 일반적으로 계층적 프로세스 모델 형태로 구성 가능. 단계/태스크/스텝 3계층으로 구성

① 최상위 계층 - 단계(Phase)

- 프로세스 그룹을 통해 완성된 단계별 산출물 생성

- 각 단계는 기준선으로 설정되어 관리 필요. 버전관리를 통해 통제 필요.

② 중간 계층 - 태스크(Task)

- 각 태스크는 단계를 구성하는 단위 활동

- 물리적 또는 논리적 단위로 품질검토 가능

③ 최하위 계층 - 스텝(Step)

- WBS의 워크패키지. 입력자료 / 처리 및 도구 / 출력자료 로 구성된 단위 프로세스

* 소프트웨어개발생명주기(SDLC : S/W Dev. Life Cycle) 활용

※ SDLC : S/W 전생애주기(요구분석-설계-구현-설치-운영-폐기) 전 과정을 가시적으로 표현한 것, S/W위기 대처, 효과적 개발, 고품질 생산성 확보 등의 효과가 있다. 계획 / 요구분석 / 설계 / 구현 / 시험 / 유지보수 총 6단계로 구성

- 빅데이터 분석 방법은 일반적으론 계층적 프로세스 모델을 따르지만 SDLC를 활용할 수도 있다.

- 폭포수 모형 / 프로토타입모형 / 나선형 모형 / 반복적 모형 등의 모형이 있으며,

프로젝트 규모와 성격 / 개발 방법 및 도구 / 개발 소요 시간 및 비용 / 산출물 인도방식 등으로 모형을 결정한다.

* KDD 분석 방법론 (Knowledge Discovery in Database)

데이터에서 패턴이나 지식을 탐색하기 위해 9개의 프로세스를 제시하는 프로파일링 기술 기반의 데이터 마이닝 기법

※ Biz.이해 → 데이터셋 선택/생성 → 전처리 → 변수선택/차원축소 → 기법선택 → 알고리즘선택 → 데이터마이닝 → 해석 → 활용

데이터 분석은 아래 5단계 절차로 진행된다.

① 데이터셋 선택(Selection)

- DB 또는 원시(RAW)데이터에서 분석에 필요한 데이터 선택 혹은 필요 시 추가적으로 구성한다.

② 데이터 전처리(Preprocessing)

- Noise / Oulier / Missing Value를 식별하고 제거하거나 대체한다. 필요시 데이터 선택 재수행한다.

③ 데이터 변환(Transformation)

- 목적에 맞는 변수를 선택하거나 차원을 축소한다. 학습용/검증용 데이터를 분리한다.

④ 데이터 마이닝(Data Mining)

- 목적에 맞는 마이닝 기법 혹은 알고리즘을 선택하고 분석을 수행한다. 필요시 전처리/변환 절차를 추가 실행.

⑤ 결과 평가(Interpretation/Evaluation)

- 분석 결과 해석과 분석 목적의 일치성을 파악하고 업무에 활용하기 위한 방안을 모색한다.

필요한 경우 앞의 과정을 반복 수행하며 결과를 향상시킨다.

* CRISP-DM 분석 방법론 (Cross Industry Standard Process for Data Mining)

계층적 프로세스 모델로써 아래 4계층으로 구성된 데이터마이닝 프로세스.

① Phases(최상위 레벨, 여러 개의 단계로 구성)

② Generic Tasks(일반화 태스크 : DM의 단일 프로세스 완전히 수행)

③ Specialized Tasks(세분화 태스크 : 일반화 태스크를 구체적으로 수행)

④ Process Instances(프로세스 실행 : 데이터마이닝을 구체적으로 실행)

분석절차는 아래 총 6단계 절차로 진행된다.

① 업무 이해 (Biz. Understanding) : 도메인 지식을 데이터 분석 문제정의로 변경 → 초기 프로젝트 계획 수립

- 업무 목적 파악 / 상황 파악 / 데이터 마이닝 목표 설정 / 프로젝트 계획 수립

② 데이터 이해 (Data Understanding) : 분석을 위해 데이터 수집 및 속성을 파악. 인사이트 발견 단계

- 초기 데이터 수집 / 데이터 기술 분석 / 탐색 / 품질 확인

③ 데이터 준비 (Data Preparation) : 분석 기법에 적합한 데이터로 변환

- 데이터셋 선택 / 정제 / 통합 / 포맷팅 등

④ 모델링 (Modeling) : 알고리즘을 선택하고 파라미터를 최적화한다 → 테스트 데이터로 과적합 등 경향 파악

- 모델링 기법 선택 / 테스트 계획 설계 / 모형 작성 / 모형 평가

⑤ 평가 (Evaluation) : 프로젝트 목적에 부합한지 확인, 결과 수용 여부 판단

- 분석결과 평가 / 모델링 과정 평가 / 모형 적용성 평가

⑥ 전개 (Deployment) : 업무 적용 계획 수립 및 유지보수 계획을 마련하고, 프로젝트 완료

- 전개 계획 수립 / 모니터링 및 유지보수 계획 수립 / 종료 보고서 작성 및 리뷰

* SEMMA 분석 방법론 (Sample, Explore, Modify, Model and Assess)

SAS 에서 만든 데이터 마이닝 프로세스로, 추출/탐색/수정/모델링/평가 총 5단계 절차로 진행되며, 기술과 통계 중심의 데이터마이닝 프로세스임.

① 추출 (Sample) : 통계적 추출, 조건 추출 등 분석용/평가용 데이터 준비

② 탐색 (Explore) : 분석용 데이터를 탐색하고 Biz.이해, 데이터 오류 확인

- 그래프 / 기초통계 / Clustering / 변수 유의성 및 상관ㅂ누석

③ 수정 (Modify) : 분석용 데이터 변환, 데이터 표현 극대화, 파생 변수 생성 등

- 수량화 / 표준화 / 변환 / 그룹화

④ 모델링 (Model) : 분석 모델 구축, 패턴 발견, 모델링 및 알고리즘 적용

- 인공신경망 / 의사결정나무 / 통계기법 등

⑤ 평가 (Assess) : 모델 평가 및 검증, 모델간 비교

- Report / Feedback / 모델검증자료 등

6) 빅데이터 분석 방법론

대량 데이터 분석을 위해 기존 데이터 분석 방법론이 발전된 형태. 마찬가지로 3계층(단계/테스크/스텝)으로 구성됨

* 5단계 개발 절차 (PPADD로 암기)

① 분석 기획 (Planning)

(1) Biz.이해 & 범위 설정 : 프로젝트 진행 방향 및 목적에 부합한 범위 설정하여 구조화된 명세서 작성

(2) 프로젝트 정의 및 계획 수립 : 모형 운영 Big Picture / 모형 평가 기준 / 목표 및 KPI / 산출물 중심 수행계획(WBS)

(3) 프로젝트 위험 계획 수립 : 발생가능한 Risk 및 대응방안(회피/전이/완화/수용으로 구분) 수립 및 관리 계획서 작성

② 데이터 준비 (Preparing)

(1) 데이터 정의 : 정형/비정형/반정형 등 모든 데이터 대상, 데이터 속성/오너/담당(협조)/개인정보/보안/법적이슈/인터페이스 확인

(2) 데이터 스토어 설계 : 정형/비정형/반정형 모두 저장할 수 있는 논리적/물리적 설계 수행

※ 정형 데이터 스토어는 일반적으로 RDB를 사용. 비정형/반정형은 하둡, NoSQL등 활용

(3) 데이터 수집 및 정합성 점검 : 데이터 거버넌스에 근거, 메타데이터 및 데이터 Dict. 등 주기적 점검 및 품질 보완

※ 크롤링 / 시스템 간 실시간 처리 / 배치 처리 / DB연동 / API 이용한 개발 / ETL도구활용 / 스크립트 작성 등

③ 데이터 분석 (Analyzing)

(1) 분석용 데이터 준비 : 분석 데이터 범위 확인 후 구조화된 형태로 구성. 필요 시 분석용 작업 공간과 전사 차원의 데이터 스토어로 분리

(2) 텍스트 분석 : 데이터 스토어에서 텍스트 데이터 추출하여 분석&모델링. 텍스트 시각화 도구로 의미전달 명확화

※ 텍스트 분석을 위해 용어사전이 정의되어야 하며 업무 도메인에 맞도록 작성 필요

(3) 탐색적 분석 : 분석용 데이터셋의 정합성검토/데이터요약/특성파악/모델링 데이터 편성/통계특성파악/시각화

(4) 모델링 : 훈련용 데이터 활용 기계학습 등 데이터 모델링(예측/군집 등). 알고리즘 설명서 및 모니터링 방안 수립

(5) 모델 평가 및 검증 : PTJ 정의서의 평가 기준 의거한 평가. 테스트용 데이터나 신규데이터 활용 객관성/적용성 검증

④ 시스템 구현 (Developing)

(1) 설계 및 구현 : 시스템 및 데이터아키텍처, 사용자 인터페이스(UI)설계서 작성. BI툴이나 P/G으로 구현

(2) 시스템 테스트 및 운영 : 시스템 품질관리 차원으로, 시스템 객관성/완전성 확보 + 운영자/사용자 대상 교육 실시

⑤ 평가 및 전개 (Deploying)

(1) 모델 발전 계획 수립 : 모델 생명주기 설정 및 주기적인 평가/유지보수/재구축/발전계획 상세 수립(계속성 확보)

(2) 프로젝트 평가 및 보고 : 정량/정성적 성과를 나눠 성과 평가서 작성. 산출물 자산화

7) 데이터 분석 거버넌스

* 데이터 분석 거버넌스 개요

① 필요성 : 분석 업무를 하나의 기업문화로 정착, 이를 지속적으로 고도화하기 위해 필요

② 구성요소

- 분석 기획/관리를 수행하는 조직 (Organization)

- 분석 과제 기획과 운영 프로세스 (Process)

- 지원 인프라 (System)

- 데이터 거버넌스 (Data)

- 분석 교육 및 마인드 육성 체계 (HR)

(1) 운영 조직 (Organization) - 이전글(빅데이터 개요 및 활용) 참조

(2) 과제 기획/운영 프로세스 (Process)

- 조직 내 데이터 분석 문화 내재화 통한 경쟁력 확보 가능

- 결과물 축적 및 관리를 통해 향후 유사 분석 과제 수행 시 시행착오 최소화

[발굴 단계] 분석 아이디어 발굴 및 과제화하여 분석 과제 풀로 관리. 분석 프로젝트 선정 작업

[수행 단계] 수행 팀 구성 / 과제 진행사항 모니터링 / 과제 결과 공유 및 개선

(3) 데이터 분석 인프라 (System)

- 데이터 분석 서비스를 위한 응용P/G 실행 환경 및 기초를 이루는 컴퓨터 시스템

- 분석에 필요한 프로그래밍 / 실행 / 서비스 환경 제공

- 새로운 분석 니즈가 발생할 경우 개별시스템을 추가하지 않으면서 추가적인 서비스 제공 가능(확장성)

(4) 데이터 거버넌스 (Data)

- 모든 데이터의 정책 및 지침 / 표준화 / 운영조직과 책임 등

표준화된 관리 체계 수립 및 운영 프레임워크/저장소 구성하는 행위

※ 개별 시스템 단위로 데이터 관리 시, 데이터 중복 / 비표준화에 따른 정합성 오류 등 데이터 활용도 저하

- 데이터 거버넌스) 데이터 가용성 / 유용성 / 통합성 / 보안성 / 안전성 확보

빅데이터 거버넌스) 데이터 최적화 / 데이터 생명주기 / 카테고리별 책임자 등 빅데이터 고유 특성 반영

- 주요 관리 대상

① 마스터 데이터 : 데이터 처리 및 조작하기 위해 사용되는 기본 데이터

② 메타 데이터 : 데이터를 설명하기 위해 사용되는 데이터 (ex. 파일 생성 날짜, 시간, 작성자, 파일크기 등)

② 데이터 사전 : 데이터 자원관리를 위한 자료 이름 / 표현 방식 / 의미 / 사용방식 / 관계 등을 저장한 데이터

- 구성 요소

① 원칙(Principle) : 데이터 유지/관리 위한 지침 및 가이드. 보안/품질기준/변경관리 등

② 조직(organization) : 데이터 관리 조직의 역할과 책임. 데이터 관리자/DB관리자/데이터 아키텍트 등

③ 프로세스(Process) : 데이터 관리를 위한 활동과 체계. 작업 절차/모니터링 활동/측정활동 등

- 데이터 거버넌스 체계

① 데이터 표준화 : 표준 용어 설정 및 명명 규칙(mapping) 수립 / 메타데이터 및 데이터 사전 구축

② 데이터 관리 체계 : 표준데이터, 메타데이터, 사전(dict.) 관리 원칙 수립 / 관리 및 운영 R&R / 데이터 생명 주기 관리 방안

③ 데이터 저장소 관리

: 표준데이터터, 메타데이터 관리 위한 저장소 구축 / 시스템 인터페이스 통한 통제 / 구조 변경에 따른 사전 영향 평가 수행

④ 표준화 활동 : 거버넌스 구축 후 표준 준수 여부 주기적 점검 / 변화 관리 및 교육 / 지속적 표준화 개선 활동

(5) 육성 체계 (HR) - 분석 교육 및 마인드 육성 체계

(출처 : Private room 블로그)

(출처 : Private room 블로그) - 분석 가치 극대화 + 내재화 통해 안정적인 추진기로 접어들기 위해 필수

※ 새로운 체계 도입 시 저항이나 기존 형태로 돌아가고자 하는 관성 발생

- 단순히 도구 사용법 교육이 아닌 분석 역량 확보/강화 하는 방향으로 진행

기획자) 데이터 분석 큐레이션 교육 진행

※ “사용자가 데이터와 상호 작용하고 이해하여 분석 결과를 생성하는 데 데이터를 사용할 수 있도록 필요한 데이터 원본을 식별하고, 그 데이터를 비즈니스 컨텍스트와 연계하는 프로세스”

분석실무자) 분석 기법 및 도구 교육 진행

기존업무수행자) 분석 기회 발굴 및 시나리오 작성법 교육 진행

조직) 분석적인 사고 향상 교육 등 데이터를 바라보는 관점이나 데이터 분석/활용 등이 문화로 받아들여지도록 유도

8) 데이터 분석 수준진단

* 데이터 분석 수준진단 개요

- 현상태를 점검하여 무엇을 준비/보완 하는지 확인 + 데이터 분석 유형/방향 결정

- 6개 영역의 분석 준비도 + 3개 영역의 분석 성숙도를 동시 평가

* 분석 준비도(Readiness)

- 조직 내 데이터 분석 업무 도입 시, 현재 수준을 평가하기 위한 진단 방법

- 6가지 영역을 대상으로, 영역별 세부 항목에 대한 수준까지 파악.

일정 수준 이상 충족 시 분석 업무 도입, but. 일정 수준 이상 충족 못하면 데이터 분석 환경 우선 조성

* 분석 성숙도

- 데이터 분석 능력 / 분석 결과 활용에 대한 조직의 성숙도 수준을 평가 및 현재 상태 점검 방법

- Biz / 조직 및 역량 / IT 부문 총 3개 부문을 대상으로 실시하며, 도입 / 활용 / 확산 / 최적화 단계로 구분

- 사분면 분석을 통해 목표 / 방향 / 개선방안 수립

① 준비형 (준비도↓성숙도↓)

: 기업에 필요한 데이터/인력/조직/분석업무/기법 등이 적용되어 있지 않아 사전준비가 필요한 기업

② 도입형 (준비도↑성숙도↓)

: 분석업무/기법 등 기술은 부족하지만 조직/데이터 등 준비가 높아 바로 도입할 수 있는 기업

③ 정착형 (준비도↓성숙도↑)

: 준비도는 낮으나 조직/인력/분석업무/기법 등 내부에서 제한적으로 사용하는 등 1차적 정착 필요한 기업

④ 확산형 (준비도↑성숙도↑)

: 필요한 6가지 구성요소 갖추고 있고, 부분적으로 도입되어 지속적 환산이 필요한 기업

![[빅분기] PART4. 빅데이터 결과 해석 - 분석결과 해석 및 활용 - 분석결과 활용 (출제빈도 : 하)](https://blogger.googleusercontent.com/img/b/R29vZ2xl/AVvXsEj2tCMzQ5D2rhqkDfbphh9LKohFnYl3Df8LahM8gskD0BNHA5jX1MLhVIuG78S5IdyrrQrB60ygONq5FvYBLzrUnJrOhKpTfTFzZP0TFS_lZDipN44DhIq8FfFfnieRwTSzDCXvKacFQWvlcETOaoxXS0KNSFdN3apRHi5ReqUer7jCvbIFp2tj8Gmqci3S/w680/%EB%B9%85%EB%8D%B0%EC%9D%B4%ED%84%B0%20%EA%B5%AC%EC%B6%95%EB%B0%A9%EB%B2%95%EB%A1%A0%20%EB%B9%84%EA%B5%90.png)

0 댓글